Pendant longtemps, mon adresse mail principale a été gérée par le FAI de la famille; une adresse en @neuf.fr en l’occurrence. J’ai jonglé et jongle encore entre plusieurs adresses mails, en fonction des cas et des besoins. Je crois que j’ai pris conscience de l’importance de l’adresse mail que l’on communique (la principale, pas celle pour le spam), le jour où, en pleine recherche de stage, le serveur mail de mon école d’ingénieur s’est écroulé et est resté inaccessible pendant une petite semaine. Pas terrible, lorsque l’adresse mail qui figure sur votre CV retourne un mail d’erreur technique. On reste heureusement joignable par l’intermédiaire plus traditionnel du téléphone. Bref, dans les deux jours qui suivaient, j’avais changé l’adresse mail de mon CV par mon adresse principale FAI.

Et voilà qu’il y a de cela deux années, la question est revenue sur le devant la table. Après avoir repris le contrôle sur un certain nombre de mes données en hébergeant mes propres services, je me suis tourné vers le problème de l’adresse mail. Il faut savoir qu’en France, une adresse FAI n’est pas immuable. Tant qu’on reste chez ce FAI, pas de problème, mais dès lors que l’on résilie son abonnement, les risques apparaissent. En effet, en cas de résiliation, le fournisseur a l’obligation légale de maintenir l’accès à l’adresse pour une durée de 6 mois. Après 6 mois, la décision de conserver l’adresse mail ou de la supprimer pour pouvoir la réattribuer est à la discrétion de l’opérateur. En règle générale, les pratiques diffèrent donc d’un fournisseur à l’autre, certains garantissent la pérennité de l’adresse sans limite de temps, d’autres avec condition « d’activité » par période de 6 mois. Il est donc préférable d’éviter d’utiliser une adresse mail FAI comme adresse principale de contact, sachant que l’on peut être amené à changer de fournisseur pour l’une ou l’autre raisons.

Se pose également la question de la confiance. Bien évidemment, les mails que nous envoyons transitent en clair sur le réseau, et si les communications peuvent être éventuellement chiffrés entre les serveurs par lesquels le mail passera, celui-ci reste en clair au niveau de chaque serveur le temps d’être transféré vers le serveur suivant. On s’intéresse davantage ici à la confidentialité des données. En clair, dans quelle mesure faisons-nous confiance à l’hébergeur de notre adresse pour que celui-ci ne consulte pas le contenu de nos mails entrants et sortants; comme le fait Google à l’aide d’algorithmes pour proposer de la publicité ciblée dans son interface web ?

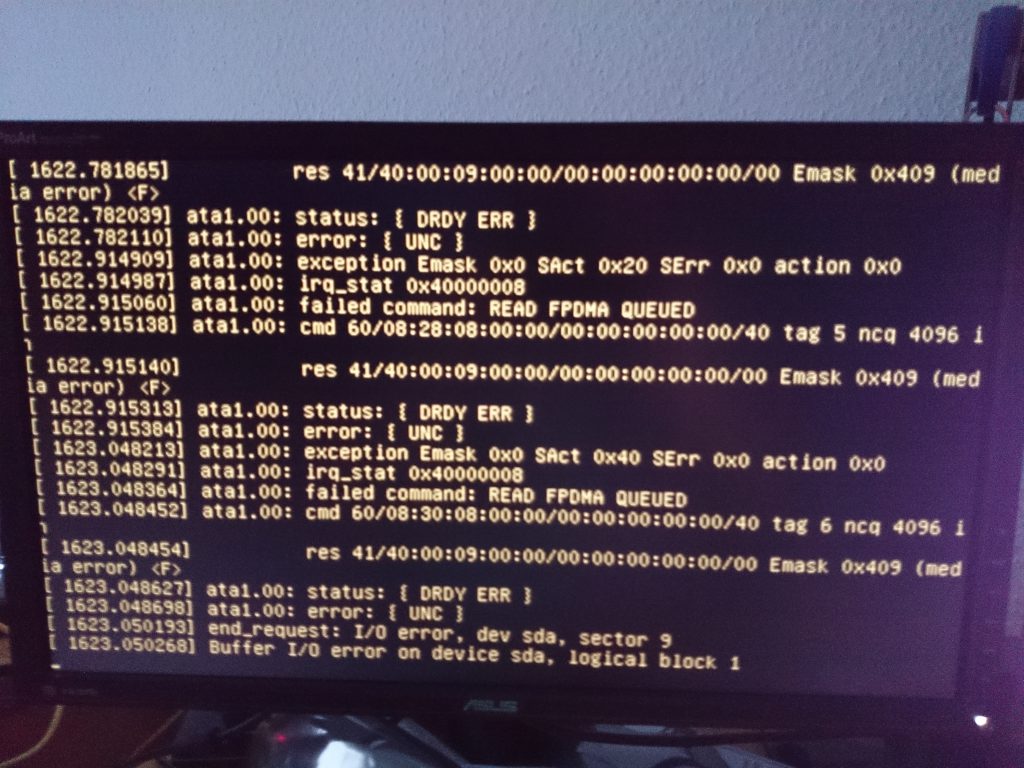

Ayant réfléchi à de nombreuses reprises, à l’hébergement de mon propre serveur mail, mais l’ayant toujours repoussé pour divers raisons (relative complexité, gestion du spam, mise en liste blanche de l’IP du serveur, redondance en cas de panne ou d’indisponibilité…), je me suis tourné vers une solution intermédiaire : prendre un nouveau nom de domaine chez un hébergeur proposant une solution mail associée. Ainsi, j’obtiens le premier maillon, le nom de domaine et peux par la suite rediriger les mails vers mon propre serveur. J’ai donc enregistré un nom de domaine chez Gandi puisque leur offre inclut la possibilité de créer 5 boîtes mail pour 1Go d’espace total partagé, redirection, alias, antivirus et anti-spam, avec possibilité de passer sur une offre payante spécifique pour le mail. Cette solution permet également d’envisager si nécessaire, le passage vers une offre payante chez ProtonMail, avec gestion de nom de domaine personnalisé.

Voici quelques points que j’ai noté pour mon changement d’adresse mail :

- Ne pas se précipiter, prendre son temps. Cela ne sert à rien d’espérer tout changer en quelques jours, il faudra du temps pour s’assurer que nos contacts utilisent notre nouvelle adresse.

- Migrer progressivement tous les comptes vers la nouvelle adresse. En effectuant la migration sur plusieurs mois, on constate au fur et à mesure quels services ne disposent pas de la nouvelle adresse.

- Éventuellement et si possible, mettre en place un message de réponse automatique sur l’ancienne adresse pour indiquer le changement d’adresse.

Par ailleurs, ce travail de migration se trouve grandement simplifié lorsqu’on possède déjà la liste de ses comptes dans un Keepass ou équivalent. On connaît alors tous les endroits où le changement d’adresse est à effectuer; mais en contrepartie, toutes les entrées utilisant l’ancienne adresse sont à mettre à jour.

La question essentielle à se poser me semble être : « A qui puis-je faire confiance pour gérer mes mails et dans quelle mesure ? ».

PS: Reste toujours le même problème que si l’un de nos contacts à son adresse chez un fournisseur auquel nous ne faisons pas confiance, celui-ci dispose tout de même d’une copie de nos échanges. (A moins de chiffrer évidemment).